Como todo en la vida, la tecnología puede ser aprovechada para aspectos que mejoran nuestra vida productiva y por igual, las mentes torcidas no tardan en aprovechar la misma tecnología para mejorar sus actividades delictivas.

En ésta ocasión quiero comentar diversos usos de avances en inteligencia artificial que se han aprovechado para estafar o chantajear a sus víctimas.

Si bien son muchos los casos quiero exponer 2 de ellos:

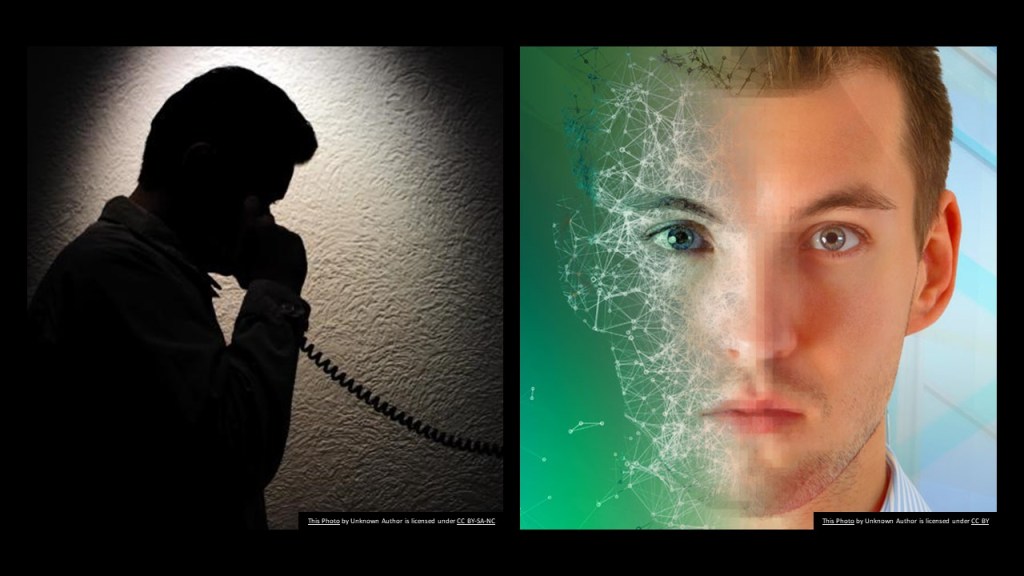

Deepfake: perjudicando tu persona

Hace algunos años hablé del Deepfake y el fin de la privacidad, donde si te interesa saber más del tema puedes presionar aquí para ir a ese episodio. Sin embargo de ese tiempo para acá, las aplicaciones para crear Deepfake han aumentado, muchas son gratis o pueden usarse por muy poco dinero, y esto ha provocado un aumento importante de maleantes aprovechando esta tecnología para robar tu identidad al modificar documentos oficiales copiando tu imagen personal, pero en especial hay un grupo de personas del crimen organizado produciendo videos en donde se suplanta la identidad de un artista con tus facciones, haciendo actos sexuales, de vandalismo o incluso aparentando haber hecho un robo, asalto o golpiza en un ambiente público.

El nivel de realismo es impresionante, a tal nivel que, a pesar de que tu no hayas hecho nada de esto, los criminales amenazan con hacer publica esa información en caso en el que tu no accedas a pagarles una suma económica.

Para protegerse de esta situación se pueden tomar varias acciones.

- Existen aplicaciones anti-deepfake que colocan firmas digitales o marcas de agua que alertan de un mal uso cuando estas son empleadas o modificadas.

- Se debe tener conciencia de quien permite ser filmado, cuando y por quién. Ya no es momento de dejar a cualquiera tomarnos fotos o videos.

- El empleo de Blockchain puede ser una buena solución para autentificar videos propios, pues es casi imposible de vulnerar la información, haciendo a este tipo de servicio de almacenamiento una gran oportunidad para mantener la fidelidad e integridad personal.

- Siempre tener soporte legal de quien recibe información digital, en especial fotografías o videos de nuestra persona, donde se hace responsable al receptor del buen uso de la información

Entre los principales puntos.

Robo de la identidad de tu voz por inteligencia artificial

Más delicado aún es el caso de herramientas de inteligencia artificial capaces de reproducir nuestras voces de forma casi perfecta, con solo tener 20 segundos de reproducción de nuestras voces, que pudieron ser grabadas en una llamada telefónica, en un video en una red social, podcast, etcétera.

La forma en la que un estafador opera es efectuando una llamada a un familiar o conocido de la persona a la que le ha clonado la voz y puede sostener una conversación con esa persona conocida haciéndola creer que es quien dice ser.

Lo normal es que solicita algún tipo de apoyo económico o envío de información delicada de tipo bancaria o similar para robar todo lo que sea de valor en el menor tiempo posible.

Por lo anterior, no basta escuchar a un ser querido tal cual como si fuera quien estamos creyendo que es. Lo ideal es aparentar que no se escucha bien, colgar y volverle a llamar. Si no responde, se debe de llamar a un ser querido que pueda validar la ubicación de esa persona, pero sobre todo controlar la comunicación desde nuestra propia perspectiva.

Tenemos que recordar que también hay tecnología para clonar el teléfono de ese ser querido o institución bancaria, por lo que no es suficiente esto para considerar que esa llamada es real.

También se da el caso del empleo de nuestra voz para dar instrucciones a personas con las que hacemos negocios, sean ejecutivos bancarios o colegas del trabajo, por lo que, de nuevo, es necesario pedir a nuestros conocidos que cuando se les llame ellos cuelguen y originen la llamada de regreso para validar que somos quienes decimos ser.

Conclusiones

Se pueden tener ciertas acciones preventivas para que algún ataque de Deepfake no sea fácil de realizar. Dentro de los principales puntos están:

- Alertar a amistades, familiares, colegas y proveedores de cómo suceden estos ataques

- En el caso de cuestiones por voz, como llamadas telefónicas se deben establecer mecanismos de validación para entonces creer lo que se dice. Esto puede ser mediante palabras clave y previo a ello que cuando se solicite algo se interrumpa la comunicación y quien recibe la llamada o contacto origine una nueva llamada o contacto con la persona original para asegurarse de que se trata de quien consideramos que es.

- En el caso de videos o fotografías emplear programas para marcas de agua que alerten a una persona cuando un video o imagen está siendo manipulada.

- Si se trata de video llamadas, sesiones web o equivalentes, se puede pedir a la persona en vivo que ponga su mano frente a su cara y que gire el cuello.

- Finalmente, si es algo “muy delicado” la sugerencia es verse en persona.

3 respuestas a “Inteligencia artificial al servicio de los estafadores: ¿como defendernos?”